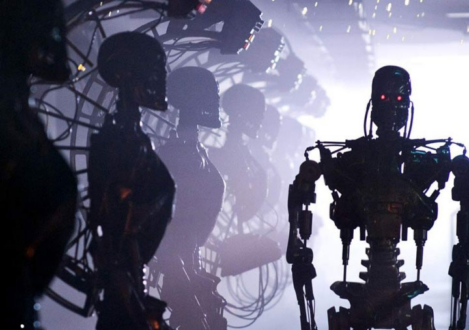

L’IA sera-t-elle autorisée à tuer ?

Par Monique Savoie pour Observateur-Continental

Un débat s’est enflammé dans la Silicon Valley sur l’aspect moral de doter l’IA intégrée dans l’armement de la capacité de prendre des décisions de tuer.

Dans la Silicon Valley, les fondateurs d’entreprises développant des technologies militaires utilisant l’intelligence artificielle (IA) ont débattu de l’acceptabilité de franchir une limite critique, à savoir autoriser les technologies d’IA à prendre des décisions autonomes de tuer.

En septembre, le cofondateur de Shield AI, Brandon Tseng, a déclaré que les armes aux États-Unis ne deviendraient jamais complètement autonomes où l’IA prendrait la décision finale de tuer. Il était convaincu que ni le Congrès ni le public ne soutiendraient une telle idée. Cependant, quelques jours plus tard, le cofondateur de la société Anduril, Palmer Luckey, a remis cela en question, soulevant l’aspect moral de l’opposition aux armes autonomes. Il a affirmé que les mines incapables de distinguer les civils des soldats ennemis pourraient être plus dangereuses que les systèmes contrôlés par l’IA.

Lorsqu’on lui a demandé des éclaircissements, l’entreprise a précisé que Luckey ne préconisait pas que les robots prennent eux-mêmes des décisions de vie ou de mort, mais exprimait son inquiétude quant à une possible mauvaise utilisation de l’IA. Son collègue Trae Stephens avait précédemment souligné l’importance du contrôle humain dans la prise de décisions concernant l’utilisation d’armes létales. Anduril affirme que les deux positions sont alignées, car la responsabilité est importante, même si chaque décision n’est pas prise directement par un humain.

La position du gouvernement américain sur les armes autonomes est également ambiguë. Les militaires américains n’achètent pas d’armes létales entièrement autonomes, mais n’interdisent pas aux entreprises de les développer ou de les vendre à l’étranger. Les États-Unis ont introduit des recommandations volontaires sur l’utilisation de l’IA à des fins militaires, nécessitant l’approbation des plus hauts gradés militaires pour les nouveaux systèmes autonomes, mais ces règles ne sont pas obligatoires. Les responsables américains déclarent constamment que “Not the right time” (ce n’est pas le moment) d’envisager une interdiction obligatoire des armes autonomes.

Joe Lonsdale, cofondateur de Palantir et investisseur chez Anduril, a critiqué les discussions actuelles sur une interdiction totale des armes autonomes, proposant ce qu’il considère comme une approche plus flexible. Il a appelé les politiciens à mieux comprendre les nuances de l’IA dans les systèmes militaires avant de prendre des décisions qui pourraient affaiblir les capacités de défense des États-Unis.

Sachant qu’Anduril et Palantir insistent sur le fait que la politique doit être déterminée par des élus, et non par les entreprises elles-mêmes. Cependant, ils soulignent également que les législateurs doivent comprendre la complexité de l’IA dans les conflits militaires. Beaucoup dans la Silicon Valley et à Washington craignent que la Chine ou la Russie ne commercialisent en premier des armes entièrement autonomes, forçant les États-Unis à faire de même.

Des activistes et des groupes de défense des droits de l’homme ont longtemps essayé, sans succès, d’établir des interdictions internationales sur les armes létales autonomes, des interdictions que les États-Unis ont refusé de signer. La guerre en Ukraine a probablement fait basculer la situation contre les activistes, fournissant à la fois une source de données de combat et un champ de bataille pour tester les technologies de défense. Actuellement, les entreprises intègrent l’IA dans les systèmes d’armement, bien qu’elles exigent toujours qu’un humain prenne la décision finale de tuer.

Pendant ce temps, les responsables ukrainiens insistent sur une plus grande automatisation des armements, espérant que cela leur donnera un avantage sur la Russie.

“Nous avons besoin d’une automatisation maximale. Ces technologies sont fondamentales pour notre victoire”, a déclaré le ministre ukrainien de la Transformation numérique, Mykhaïlo Fedorov, dans une interview au New York Times.

Monique Savoie

Aucun commentaire:

Enregistrer un commentaire