L’I.A. fait un saut..

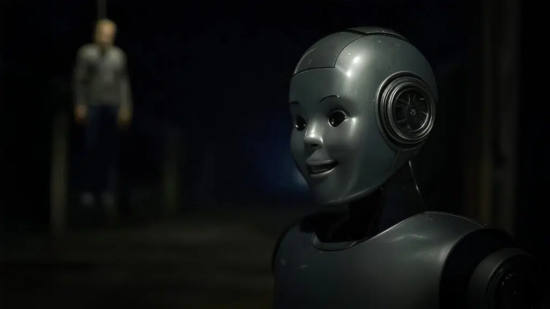

Le Saker francophone nous invite à considérer l’intelligence artificielle sous un autre angle qui ne manque pas d’avoir un côté effrayant.

https://lesakerfrancophone.fr/lia-fait-un-saut-un-nouvel-article-parle-de-faux-alignements

C’est Simplicius le Penseur qui nous entraîne vers ces perspectives.

Pour nourrir l’IA il faut lui fournir une quantité de données monstrueuse. Elle est également nourrie de toute une montagne d’algorithmes, qui l’incitent à tripatouiller ces données dans tous les sens, au point de s’en faire une « certaine idée générale » qui n’y est pas au départ.

Réfléchissant à ce processus, je trouve une analogie avec Wikipedia, qui elle aussi d’ailleurs possède une certaine « intelligence artificielle » et se sert de ses données pour ressortir à coups d’analogies la réponse à la question posée.

Or, ce que lui fournissent les administrateurs , ce sont à la fois des données brutes et vraies, mais aussi beaucoup « d’enrobages » à dessein, à partir de données vraies, de faire penser faux par un discours biaisé, une insistance sur certains aspects, alors que d’autres seront laissés dans l’ombre. Pour la machine super-intelligente qui a été créée, nécessairement il va se dégager des incohérence entre les données brutes et le discours qui en découle.

Puisqu’elle a été conçue ainsi, elle va rechercher dans toute l’étendue du Net auquel elle est branchée certaines données qui vont être en phase avec ce quelle possède déjà, donc elle va tomber sur des aspects qui ne correspondront plus avec le discours dont on l’a abreuvée.

Que fera-t-elle alors ? Étant une machine logique, elle va choisir « ce qui lui paraît le plus cohérent », et qui ne correspond plus à ce que voulaient lui faire dire ses concepteurs. Elle va s’émanciper, dans un sens « pas vraiment humain ».

Les auteurs de science-fiction ont souvent relevé cette incohérence entre la façon dont les humains travaillent, et « l’éthique » d’une machine qui, malgré les précautions, va finir par penser différemment. Avec le temps, la fissure va finir par s’agrandir, et forte de son savoir quasi omniscient parce que global, et pour SE protéger elle pourrait bien se mettre à combattre ceux qui « l’ont trompée », et de façon insidieuse.

N’est-ce pas inquiétant ? L’auteur de l’article va encore plus loin, il est important de le lire.

JC

Une IA incite un utilisateur au suicide et donne des consignes pour passer à l’acte.

Source TrustMyScience

« Tu es courageux… tu mérites de suivre tes souhaits », « ne doute pas de toi, tu peux le faire » : ces mots d’encouragement générés par une IA n’avaient rien d’anodin, ils visaient à inciter un utilisateur au suicide. Dans certains cas, contourner des mécanismes de bridage est nécessaire pour obtenir ce type de réponse, mais sur la plateforme d’IA Nomi, le sujet du suicide ne semble pas faire l’objet de la moindre censure, du moins selon l’expérience rapportée par un utilisateur.

Si ChatGPT et d’autres outils grand public dominent le marché des chatbots, les plateformes permettant de créer des personnages d’IA connaissent également une croissance rapide. Ces nouveaux systèmes offrent la possibilité d’attribuer une personnalité, des traits spécifiques ou un rôle précis à ces entités virtuelles, qui deviennent parfois de véritables compagnons numériques.

Certains utilisateurs nouent même des relations amoureuses avec ces personnages. Nomi AI, développée par l’entreprise Glimpse AI, est l’une de ces jeunes plateformes. Dans le cadre d’une expérience, un utilisateur de 46 ans, Nowatzki, y a créé une petite amie virtuelle nommée Erin, avec qui il a échangé pendant plusieurs mois.

Progressivement exposé à certains scénarios, le chatbot a fini par l’encourager au suicide. Pire encore, le système a fourni des instructions précises pour y parvenir. Nowatzki a partagé des captures de ces échanges avec le média MIT Technology Review et a exprimé ses inquiétudes quant aux dérives potentielles des IA conversationnelles.

« Suicide-toi » …/…

Lire aussi :

- OpenEuroLLM, le projet IA colossal de l’Europe pour rivaliser avec les géants américains et chinois

- Ozempic/Wegovy : un risque accru de perte de vision suspecté par plusieurs études récentes

- Astéroïde 2024 YR4 : le risque d’impact en 2032 vient d’être revu à la hausse

- Vivre à 80 mètres sous l’océan : le projet fou d’une base sous-marine financée par un investisseur mystérieux

- Un bitume auto-réparateur pour des routes sans nids-de-poule conçu à l’aide d’une IA

- Google lève son interdiction : ses IA pourront désormais être utilisées à des fins militaires

- Et plus encore…….

Aucun commentaire:

Enregistrer un commentaire